Principaux enseignements

- SPS Software grands SPS Software ne deviennent utiles pour le travail en temps réel que lorsque la structure, les paramètres du solveur et le traitement des données sont réglés avec le même soin que la conception électrique elle-même.

- La simplification de la hiérarchie, la sélection de la bonne stratégie de résolution et le remplacement des composants détaillés non essentiels par des modèles réduits peuvent réduire considérablement les temps d'exécution sans sacrifier les aspects physiques importants.

- Le profilage est un moyen pratique de voir où les simulations prennent réellement du temps, ce qui vous aide à concentrer l'optimisation sur les sous-systèmes, les boucles de contrôle et les choix d'enregistrement spécifiques qui ont le plus d'impact.

- Une gestion rigoureuse des fréquences d'échantillonnage, des marges de synchronisation et de l'utilisation de la mémoire améliore à la fois la précision numérique et le débit, ce qui vous permet d'exécuter davantage de scénarios et d'obtenir des informations plus claires pour chacun d'entre eux.

- SPS Software un flux de travail intégré pour l'optimisation des modèles MATLAB, aidant les ingénieurs, les enseignants et les chercheurs à passer en toute confiance des analyses hors ligne à des cibles en temps réel pour les modèles de simulation volumineux.

Tout ingénieur qui a déjà vu une barre de progression avancer lentement pendant une longue simulation sait à quel point un modèle lent peut être pénible. SPS Software volumineux peuvent être riches en détails, mais cette complexité entraîne souvent des retards dans les délais en temps réel et des blocages dans le travail. Vous pouvez vous retrouver avec des contrôleurs en attente de signaux, des processeurs utilisés à pleine capacité et des configurations matérielles en boucle qui ne peuvent tout simplement pas suivre. L'optimisation de ces grands modèles de simulation en termes de vitesse et de robustesse transforme la frustration en délais prévisibles, des résultats plus clairs et des journées de test plus sereines.

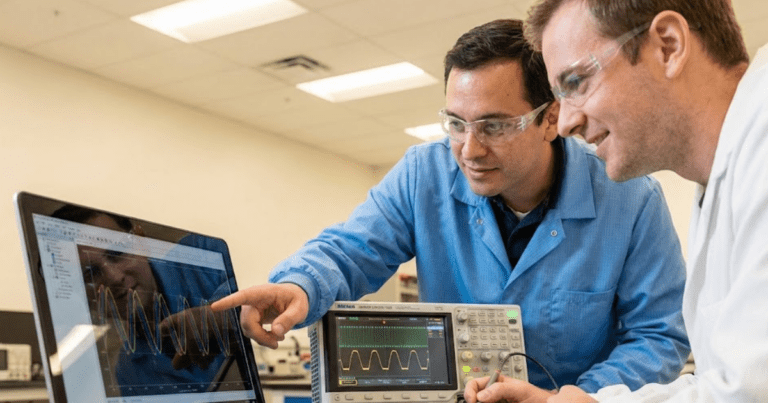

Les ingénieurs en systèmes d'alimentation, les spécialistes en électronique de puissance, les planificateurs de réseaux et les chercheurs ressentent tous cette pression lorsque les modèles dépassent quelques milliers d'états. Vous avez besoin d'un comportement physique précis pour les alimentations, les convertisseurs ou les micro-réseaux, mais vous avez également besoin de simulations qui s'achèvent avant la fermeture du laboratoire. Cet équilibre devient encore plus délicat lorsque SPS Software alimentent des plateformes matérielles pour la validation en temps réel ou « hardware-in-the-loop ». Les équipes universitaires et industrielles sont confrontées à des files d'attente hors ligne, à un accès en temps réel limité et à des attentes plus élevées en matière d'études de systèmes, ce qui alourdit chaque choix de modélisation.

« L'optimisation de ces grands modèles de simulation en termes de vitesse et de robustesse transforme la frustration en délais prévisibles, des résultats plus clairs et des journées de test plus sereines. »

Pourquoi l'optimisation SPS Software à grande échelle est essentielle pour les performances en temps réel

SPS Software à grande échelle commencent souvent par des études exploratoires, avec un niveau de détail élevé partout et peu d'attention accordée au coût du solveur. Cette structure fonctionne pour les exécutions nocturnes sur un poste de travail, mais le même modèle dépasse généralement le budget temps alloué dès lors que vous ciblez un processeur en temps réel. Chaque état supplémentaire, chaque discontinuité et chaque boucle algébrique ajoute du travail pour le solveur, et cet effort se traduit par des délais non respectés et des instabilités. Lors du travail avec le matériel en boucle, ces dépassements peuvent interrompre les tests, perturber les contrôleurs ou masquer des défauts qui n'apparaissent que lorsque le timing est correct. Optimiser les grands modèles de simulation à ce stade signifie les façonner de manière à ce que chaque étape temporelle se termine dans la fenêtre en temps réel, tout en reflétant les propriétés physiques qui vous intéressent.

Les performances en temps réel ne se résument pas à la vitesse brute, car la précision souffre si le solveur prend des raccourcis pour respecter le calendrier. Des modèles plus rapides vous permettent d'explorer davantage de scénarios, de soumettre les contrôleurs à des contraintes sur des périodes plus longues et de tester des cas limites rares qui pourraient ne jamais se présenter lors d'un seul cycle long. Une fois que les résultats des cycles hors ligne et en temps réel correspondent, vous pouvez être sûr que toute défaillance observée provient de la conception et non d'artefacts numériques ou de processeurs surchargés. C'est cette combinaison de fiabilité temporelle et de formes d'onde fiables qui fait de SPS Software un outil permettant non seulement d'améliorer les performances, mais aussi de prendre de meilleures décisions techniques.

5 conseils d'optimisation pour SPS Software à grande échelle

SPS Software efficace SPS Software commence par une vision claire de l'utilisation réelle du temps de simulation. Une partie de ce coût provient de la manière dont vous structurez le modèle, et une autre partie provient des paramètres du solveur ou des choix de traitement des données. De petits changements structurels dans SPS, en particulier pour les modèles de simulation de grande taille, apportent souvent des gains plus importants que le changement de matériel ou l'ajout de cœurs de traitement. Le travail d'optimisation qui cible la structure, les solveurs, les composants, le profilage et le traitement des données s'intègre généralement directement dans la manière dont vous construisez et testez déjà les modèles.

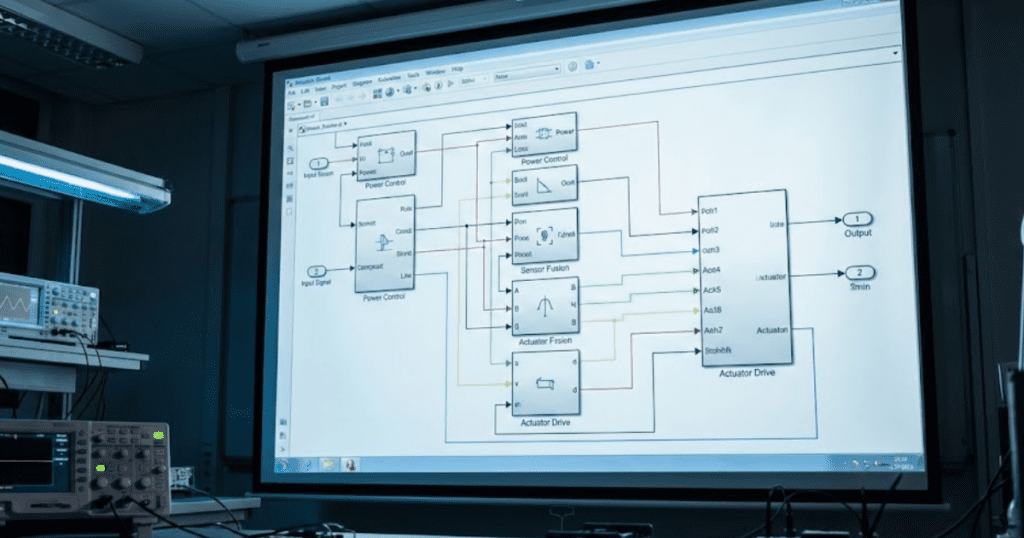

1. Simplifier la hiérarchie des modèles afin de réduire la charge du solveur

La hiérarchie complexe est souvent la première source cachée de coûts dans les modèles SPS construits à partir de diagrammes MATLAB et Simulink. L'imbrication profonde des sous-systèmes, des sous-systèmes conditionnels et des composants masqués oblige le moteur à gérer de nombreux contextes d'exécution, même lorsque le comportement électrique reste simple. Le regroupement des blocs connexes dans des sections plus plates et mieux organisées réduit cette surcharge et facilite la compréhension de l'ordre d'exécution. Vous conservez une séparation logique à des fins d'enseignement ou de documentation, tandis que le solveur voit moins de couches à parcourir à chaque étape. De nombreuses équipes créent un niveau supérieur propre dédié à la structure du système d'alimentation, puis ne poussent que la logique réutilisable essentielle dans des sous-systèmes avec des noms clairs et un imbrication minimale.

Les études portant sur les grands réseaux ou les convertisseurs comprennent souvent des alimentations, des bancs de charge ou des branches de convertisseur répétitifs qui partagent la même structure mais dont les paramètres diffèrent. La création de sous-systèmes paramétrés pour ces modèles vous permet de régler les structures à un seul endroit tout en évitant une profondeur supplémentaire due à un regroupement excessif. Vous pouvez également supprimer les couches qui ne servent qu'à la mise en page visuelle, telles que les sous-systèmes utilisés uniquement pour encadrer des blocs à l'écran, et les remplacer par des annotations ou des mises en évidence de zones. Ce type de nettoyage aide les étudiants et les ingénieurs juniors à lire le modèle plus rapidement, ce qui réduit les erreurs de modélisation qui se traduisent par la suite par des exécutions en temps réel instables. Une hiérarchie structurée qui reste peu profonde mais claire devient plus facile à transférer vers des cibles matérielles et à partager entre les équipes universitaires ou industrielles.

2. Utilisez efficacement les solveurs à pas variable pour accélérer la simulation.

Les solveurs à pas variable permettent d'accélérer les exécutions SPS hors ligne en adaptant le pas de temps lorsque les signaux changent lentement, mais ils nécessitent tout de même une configuration minutieuse. Des tolérances d'erreur trop larges, des systèmes rigides ou de nombreux éléments à commutation rapide peuvent entraîner un découpage des pas qui nuit aux gains de performance. Commencez par les paramètres de solveur recommandés pour votre combinaison de composants électriques et de contrôle, puis resserrez les tolérances uniquement lorsqu'elles affectent les résultats importants pour votre étude. Les ingénieurs constatent souvent des gains importants en matière d'optimisation des modèles MATLAB simplement en mesurant les tailles de pas dans le temps et en évitant les fluctuations extrêmes qui indiquent une contrainte sur le solveur. Une fois que le modèle hors ligne se comporte bien, vous pouvez passer à une configuration équivalente à pas fixe pour un travail en temps réel avec moins de surprises.

Pour les modèles de simulation volumineux qui combinent une dynamique électromécanique lente avec une logique de commutation ou de protection rapide, envisagez de répartir les composants sur plusieurs taux de résolution. Les états lents, tels que la dynamique mécanique des arbres ou les équivalents de grille moyennés, peuvent utiliser des étapes efficaces plus longues, tandis que les éléments de commutation et de protection ne fonctionnent sur des étapes plus courtes que lorsque cela est nécessaire. Ce type de stratégie à plusieurs taux réduit le nombre de petites étapes d'intégration qui, autrement, se propagent dans tout le système. Vous pouvez ensuite valider la précision à l'aide de superpositions dans le domaine temporel, de comparaisons dans le domaine fréquentiel ou de vérifications de l'équilibre de puissance afin de vous assurer que le réglage du solveur n'a pas masqué de comportements importants. Cette itération structurée permet de choisir le solveur en fonction des lois physiques plutôt que de procéder par essais et erreurs.

3. Remplacer les composants détaillés par des sous-systèmes simplifiés équivalents.

Les modèles de composants haute fidélité sont rassurants, mais les modèles à commutation complète pour chaque branche du convertisseur ou les réseaux détaillés pour chaque alimentation surchargent rapidement les cibles en temps réel. Les modèles moyennés, les équivalents de Thévenin ou les machines à ordre réduit capturent souvent le comportement dont vous avez besoin tout en réduisant considérablement les états et les discontinuités. Par exemple, un groupe d'onduleurs photovoltaïques alimentant un bus commun peut partager une seule interface moyennée et un ensemble plus petit de modèles détaillés utilisés uniquement lorsque les artefacts de commutation ont de l'importance. Lorsque les modèles prennent en charge l'enseignement, vous pouvez conserver des vues détaillées dans des sous-systèmes distincts et proposer des équivalents simplifiés comme valeur par défaut pour les performances. Les étudiants continuent d'apprendre comment se comporte le circuit complet, tandis que les sessions de laboratoire restent pratiques sur du matériel partagé en temps réel.

La simplification fonctionne mieux lorsqu'elle s'appuie sur des questions claires concernant les résultats importants et les entrées qui influencent le plus ces résultats. Si votre objectif est de valider le comportement du contrôleur dans des scénarios de défaillance, le modèle doit préserver la synchronisation des défaillances, les enveloppes de tension et de courant, ainsi que toutes les non-linéarités qui influencent les décisions du contrôleur. Les détails fins dans les parties éloignées du réseau ou les sous-systèmes secondaires contribuent souvent peu à ces quantités et peuvent être remplacés par des équivalents plus simples. Le fait de documenter ces choix directement dans le modèle, par exemple à l'aide d'annotations ou de contrôles de variantes, aide les futurs utilisateurs à comprendre les limites de chaque configuration. Une justification claire pour chaque sous-système simplifié rassure également les réviseurs et les promoteurs du projet sur le fait que les gains de performance ne masquent pas des aspects physiques importants.

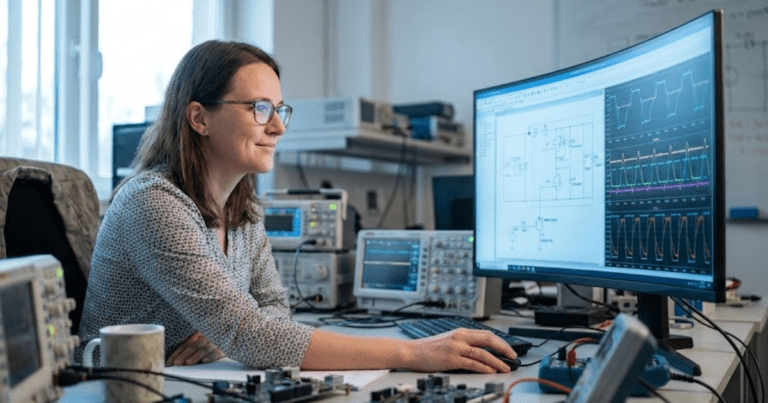

4. Exécution du modèle de profil pour identifier les goulots d'étranglement informatiques

Les outils de profilage de MATLAB et Simulink fournissent une vue concrète de l'utilisation du temps de simulation pour les modèles SPS. Au lieu d'essayer de deviner quelle partie d'un grand diagramme est lente, vous voyez exactement les fonctions, sous-systèmes et blocs qui consomment le plus d'étapes ou de cycles CPU. Les ingénieurs découvrent souvent que quelques boucles de contrôle oscillantes, des filtres de mesure à haute fréquence ou des oscilloscopes de diagnostic représentent une grande partie du temps d'exécution. La suppression des journaux inutiles, la simplification de la logique de contrôle ou le réajustement des filtres à ces endroits permettent généralement d'obtenir des gains plus importants que des modifications générales de l'ensemble du modèle. Le profilage révèle également les parties du modèle qui ne s'exécutent jamais dans un scénario donné, ce qui peut indiquer la présence de code mort, de chemins de protection inutilisés ou de fonctionnalités qui devraient être déplacées vers des cas de test distincts.

La préparation en temps réel bénéficie du profilage de plusieurs cas de test, tels que le fonctionnement normal, les défaillances et les séquences de démarrage. Certains goulots d'étranglement n'apparaissent que lors de cycles limites ou de scénarios extrêmes. Il est donc utile de profiler ces chemins avant de les déployer sur le matériel. Vous pouvez stocker les résultats du profileur avec le modèle, ce qui permet aux membres de l'équipe de revoir les décisions passées concernant les choix de solveurs et la restructuration des sous-systèmes. Ce contexte partagé évite les travaux de réglage répétés et renforce la confiance dans le fait que les optimisations sont basées sur des données mesurées plutôt que sur la seule intuition. Le profilage fait désormais partie intégrante de la culture de modélisation, tout comme les tests unitaires pour les logiciels, ce qui améliore la qualité des projets au fil du temps.

5. Pré-allouer les données et gérer l'enregistrement des signaux pour optimiser l'efficacité de la mémoire

L'utilisation de la mémoire limite souvent les modèles SPS volumineux avant même que le calcul pur ne le fasse, en particulier lorsque de nombreux signaux sont enregistrés dans l'espace de travail ou dans des fichiers externes. L'enregistrement de chaque forme d'onde en pleine résolution pour des scénarios longs crée d'énormes ensembles de données qui ralentissent à la fois la simulation et le post-traitement. Vous pouvez généralement conserver uniquement les courants, tensions et états de contrôleur clés à pleine vitesse, tout en décimant les signaux secondaires ou en les enregistrant uniquement autour d'événements spécifiques. Les contrôles d'enregistrement basés sur des modèles, les groupes de signaux et les portées conditionnelles facilitent le passage entre des configurations de débogage légères et des traces plus riches utilisées pour des études détaillées. Le fait de maintenir une empreinte mémoire modeste réduit le risque de dépassement des cibles en temps réel et raccourcit le délai entre les essais en laboratoire.

La pré-allocation de tableaux dans les fonctions ou scripts MATLAB connectés à vos modèles SPS évite une augmentation coûteuse de la mémoire pendant la simulation. L'augmentation des variables un échantillon à la fois dans la logique de contrôle ou les rappels d'enregistrement des données oblige le moteur à demander de nouvelles ressources mémoire à plusieurs reprises. Vous pouvez estimer les tailles requises à partir de la durée prévue de la simulation et des temps d'échantillonnage, puis allouer une seule fois et réutiliser les tampons dans tous les cas. Cette approche permet de garder les modèles d'accès à la mémoire prévisibles et aide les planificateurs en temps réel à maintenir des performances constantes. Une gestion propre de la mémoire s'associe bien à de bonnes pratiques d'enregistrement pour prendre en charge des campagnes de test plus longues et plus informatives sans réinitialisations fréquentes ni nettoyage manuel.

SPS Software cohérente SPS Software à tous les niveaux de la hiérarchie, des solveurs, des composants, du profilage et du traitement des données transforme les modèles volumineux en outils fiables plutôt qu'en expériences fragiles. Chaque amélioration peut sembler minime prise isolément, mais considérée à l'échelle d'un projet dans son ensemble, elle permet souvent de réduire le temps de simulation de plusieurs ordres de grandeur, et non pas seulement de quelques pourcents. Des exécutions plus courtes et plus stables libèrent du matériel en temps réel, rare, pour davantage d'utilisateurs, davantage de scénarios et des études plus ambitieuses. Cette amélioration du débit et de la fiabilité se traduit par des plannings de laboratoire plus fluides, des sessions d'enseignement plus claires et une validation plus solide pour les projets industriels.

« SPS Software cohérente SPS Software à tous les niveaux de la hiérarchie, des solveurs, des composants, du profilage et du traitement des données transforme les modèles volumineux en outils fiables plutôt qu'en expériences fragiles. »

Comment l'optimisation améliore la précision et le débit de simulation dans les systèmes en temps réel

Le travail d'optimisation des modèles commence souvent par la définition d'objectifs de performance, mais il a également des conséquences directes sur la précision. Des solveurs mal réglés, un échantillonnage incohérent ou des tâches surchargées peuvent déformer les formes d'onde, même lorsqu'une exécution semble se terminer à temps. SPS Software minutieuse SPS Software maintient les erreurs numériques, la latence et la gigue dans des limites connues, de sorte que les comparaisons entre les exécutions hors ligne et en temps réel restent significatives. Les avantages se manifestent de plusieurs manières concrètes pour les ingénieurs, les étudiants et les chercheurs qui travaillent avec des cibles en temps réel.

- Fidélité numérique supérieure : le contrôle rigoureux des paramètres du solveur réduit les erreurs d'intégration, de sorte que les courbes de tension et de courant restent plus proches des prévisions analytiques. Cette fidélité facilite la détection des petits problèmes du contrôleur, tels que la stabilité marginale ou les dépassements subtils, avant les tests matériels.

- Synchronisation plus cohérente : les modèles optimisés respectent les délais avec une marge, ce qui permet de maintenir les instants d'échantillonnage alignés sur les hypothèses du contrôleur. Une synchronisation cohérente évite les oscillations artificielles introduites uniquement par la gigue, de sorte que les défauts et les événements se produisent quand vous vous y attendez.

- Couverture scénaristique accrue par jour : des simulations plus rapides vous permettent d'exécuter davantage de niveaux de charge, de cas de défaillance et de balayages de paramètres dans le même créneau de laboratoire. Un débit plus élevé se traduit par de meilleures statistiques et une plus grande confiance lors de la présentation des résultats à vos pairs, responsables ou examinateurs.

- Comparaison plus facile entre les exécutions hors ligne et en temps réel : lorsque les deux versions du modèle se comportent de manière similaire, vous pouvez utiliser des études hors ligne pour réduire les plages de paramètres avant de passer au matériel. Cet alignement permet de gagner du temps lors de la configuration, de réduire les efforts de débogage et de clarifier les différences qui proviennent réellement du matériel cible.

- Meilleure utilisation du matériel : les modèles efficaces exploitent mieux les processeurs et les châssis en temps réel, qui sont limités, ce qui permet aux équipes de partager les plateformes sans longues listes d'attente. Les ingénieurs passent plus de temps à tester les conceptions et moins de temps à attendre qu'un créneau se libère, ce qui améliore l'apprentissage et l'avancement des projets.

- Des résultats pédagogiques et de formation plus clairs : les étudiants qui travaillent avec des modèles réactifs voient le lien entre la théorie et les formes d'onde en une seule session de laboratoire. Cette immédiateté aide à ancrer les concepts, encourage l'expérimentation avec différents réglages et renforce la confiance pour les futurs projets industriels.

L'optimisation qui améliore à la fois la précision et le débit favorise directement une meilleure compréhension technique et des processus décisionnels plus sûrs. Vous passez plus de temps à interpréter des résultats clairs et moins de temps à remettre en question le comportement du solveur ou à réexécuter des cas instables. Les équipes qui mesurent ces gains constatent souvent que la simulation devient un élément fiable de la conception et de la validation, et non plus seulement une vérification préliminaire avant les expériences. Au fil du temps, les workflows SPS bien optimisés créent un langage commun en matière de formes d'onde, de marges de synchronisation et d'objectifs de performance qui relie les salles de classe, les laboratoires de recherche et les projets industriels.

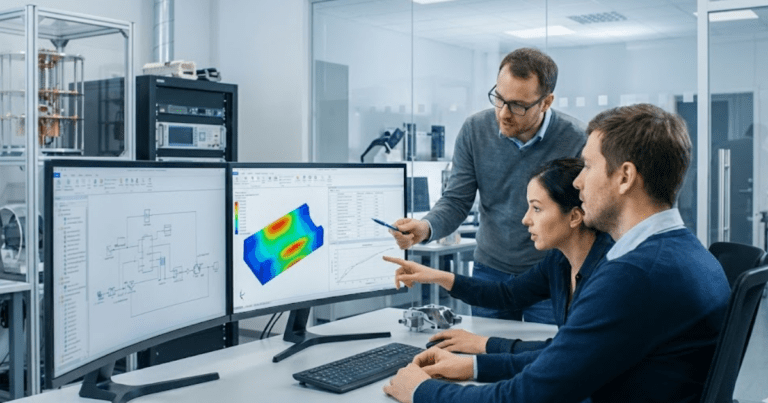

Comment SPS Software les ingénieurs à optimiser leurs modèles

SPS Software offre aux équipes de modélisation un flux de travail MATLAB et Simulink familier, avec des bibliothèques axées sur la puissance qui reflètent déjà la façon dont les ingénieurs électriciens conçoivent les systèmes. Des modèles de composants ouverts et basés sur la physique vous permettent d'inspecter les équations, d'adapter les paramètres aux réseaux locaux ou aux convertisseurs, et d'enseigner aux étudiants exactement ce que chaque bloc calcule. SPS Software parfaitement aux flux de conception basés sur des modèles, vous pouvez utiliser les mêmes diagrammes pour les études hors ligne, les balayages de paramètres automatisés et la préparation de cibles en temps réel. Cette continuité réduit les retouches et offre aux professeurs et aux ingénieurs un langage de modélisation unique à partager entre les cours, les projets de recherche et les études appliquées. Lorsque les modèles s'adaptent au temps réel, les utilisateurs de SPS peuvent s'appuyer sur des workflows établis pour la gestion de la hiérarchie, le réglage des solveurs et le profilage, qui s'alignent sur les étapes d'optimisation décrites précédemment.

Les ingénieurs qui travaillent avec le matériel OPAL-RT associent souvent SPS Software à des solveurs temps réel dédiés, de sorte que le travail d'optimisation dans SPS se traduit directement par des gains sur le simulateur cible. Les laboratoires universitaires peuvent partager des exemples de modèles, des didacticiels et des modèles de profilage entre les institutions, ce qui renforce l'enseignement tout en maintenant des configurations locales abordables. Les équipes industrielles bénéficient de la même transparence lorsqu'elles transfèrent des modèles issus d'études de faisabilité vers des bancs d'essai Hardware-in-the-Loop, car chaque simplification ou modification du solveur reste visible et vérifiable. Cette combinaison de modèles ouverts, de workflows cohérents et de pratiques d'optimisation claires positionne SPS Software un partenaire fiable pour les ingénieurs qui se soucient à la fois de la compréhension et des performances. Les équipes peuvent être assurées que le temps investi dans le réglage des modèles SPS contribue à un meilleur enseignement, à des recherches plus crédibles et à des décisions industrielles plus sûres, année après année.